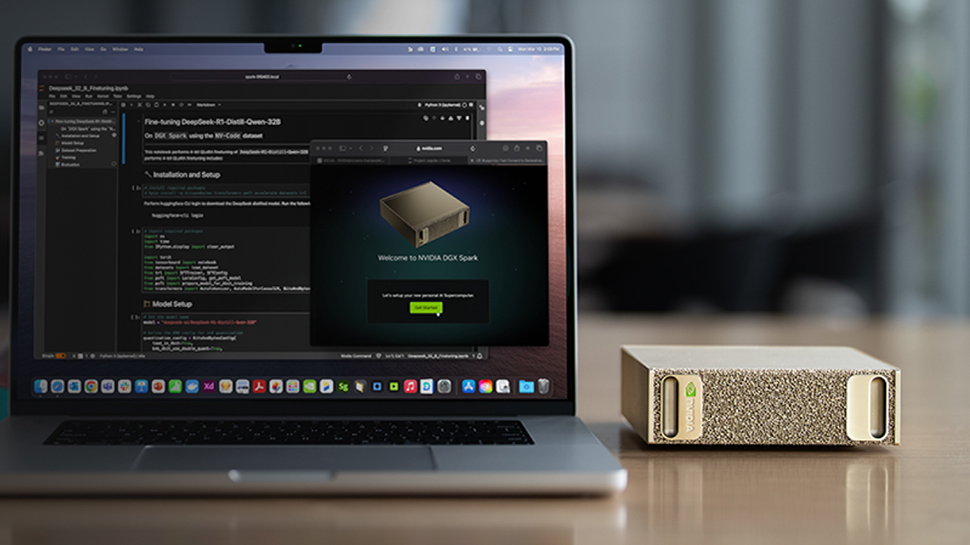

การเชื่อมต่อและใช้งาน AI บนเครื่องเซิร์ฟเวอร์ที่ทรงพลังอย่าง NVIDIA Spark นั้นจะเป็นประโยชน์ยิ่งขึ้นหากเราสามารถเข้าถึงและสั่งงานได้จากเครื่องคอมพิวเตอร์ที่เราใช้งานประจำได้อย่างสะดวกและปลอดภัย บทความนี้จะพาคุณไปเรียนรู้วิธีการติดตั้ง Ollama ซึ่งเป็นเครื่องมือยอดนิยมสำหรับรันโมเดล Large Language Model (LLM) ลงบนอุปกรณ์ NVIDIA Spark และเชื่อมต่อเข้าถึง API จากระยะไกลผ่าน NVIDIA Sync ด้วยเทคนิค SSH Tunnel ซึ่งวิธีนี้จะช่วยให้คุณไม่ต้องเปิดพอร์ตเครือข่ายที่เสี่ยงต่อการถูกโจมตี แต่ยังคงสามารถใช้พลังการประมวลผลของ GPU บนเครื่อง Spark ได้เต็มประสิทธิภาพจากเครื่อง Local Machine ของคุณเหมือนกับรันบนเครื่องตัวเอง

ในขั้นตอนนี้เราจะครอบคลุมตั้งแต่การเริ่มต้นติดตั้ง Ollama การตรวจสอบเวอร์ชัน ไปจนถึงการดาวน์โหลดโมเดล AI ขนาดใหญ่ที่เหมาะสมกับสถาปัตยกรรม GPU ของ Spark จากนั้นจะแนะนำการตั้งค่า NVIDIA Sync ในส่วนของ Custom Apps เพื่อสร้างอุโมงค์เชื่อมต่อที่ปลอดภัย และปิดท้ายด้วยการทดสอบระบบด้วยคำสั่ง cURL เพื่อยืนยันว่าเราสามารถส่งคำสั่งและรับผลลัพธ์จากโมเดลบนเครื่อง Spark ผ่านเครื่อง Local ได้สำเร็จแล้ว ทั้งหมดนี้ออกแบบมาให้ทำได้ง่าย มีความเสี่ยงต่ำ และสามารถย้อนกลับค่าเดิมได้หากไม่ต้องการใช้งานต่อ

ข้อกำหนดเบื้องต้นและการเตรียมความพร้อม

ก่อนที่จะเริ่มกระบวนการติดตั้งและตั้งค่าระบบ ผู้ใช้งานจำเป็นต้องมีอุปกรณ์ DGX Spark ที่ผ่านการตั้งค่าเรียบร้อยและเชื่อมต่อกับเครือข่ายอินเทอร์เน็ตเรียบร้อยแล้ว นอกจากนี้ยังต้องมีการติดตั้งซอฟต์แวร์ NVIDIA Sync บนเครื่องคอมพิวเตอร์ Local Machine และทำการเชื่อมต่อกับอุปกรณ์ Spark ไว้ล่วงหน้าเพื่อให้พร้อมสำหรับการส่งผ่านคำสั่งและจัดการการเชื่อมต่อระยะไกล การมีอุปกรณ์ที่พร้อมใช้งานถือเป็นหัวใจสำคัญเพื่อให้ทุกขั้นตอนต่อไปดำเนินไปได้อย่างราบรื่นโดยไม่มีสะดุดเรื่องของฮาร์ดแวร์หรือเครือข่ายพื้นฐาน

ในส่วนของความรู้พื้นฐาน ผู้ใช้งานควรมีความเข้าใจเกี่ยวกับการทำงานของ SSH (Secure Shell) ซึ่งเป็นโปรโตคอลที่ใช้ในการเชื่อมต่อเครือข่ายอย่างปลอดภัย รวมถึงความคุ้นเคยกับการใช้งาน Terminal commands และ cURL สำหรับการทดสอบการเชื่อมต่อ API ซึ่งเครื่องมือเหล่านี้จะถูกใช้อย่างแพร่หลายตลอดทั้งบทความ นอกจากนี้ การมีพื้นฐานเกี่ยวกับ REST API และการจัดรูปแบบข้อมูล JSON จะช่วยให้ผู้ใช้งานเข้าใจกระบวนการแลกเปลี่ยนข้อมูลระหว่างเครื่อง Local และเซิร์ฟเวอร์ Ollama ได้ดีขึ้น ทำให้สามารถแก้ไขปัญหาหรือปรับแต่งการใช้งานได้อย่างมั่นใจ

การติดตั้ง Ollama บน NVIDIA Spark

ตรวจสอบเวอร์ชันที่ติดตั้ง

ขั้นตอนแรกที่สำคัญก่อนจะทำการติดตั้งใหม่คือการตรวจสอบว่าบนอุปกรณ์ NVIDIA Spark มีการติดตั้งโปรแกรม Ollama ไว้แล้วหรือไม่ ผู้ใช้งานสามารถทำการเข้าถึง Terminal ของอุปกรณ์ Spark และพิมพ์คำสั่ง ollama –version เพื่อตรวจสอบสถานะ หากระบบแสดงเลขเวอร์ชันออกมาแสดงว่ามีการติดตั้งไว้แล้ว ซึ่งในกรณีนี้คุณสามารถข้ามขั้นตอนการติดตั้งใหม่และไปยังขั้นตอนการดาวน์โหลดโมเดลได้ทันที การตรวจสอบนี้ช่วยประหยัดเวลาและหลีกเลี่ยงการทำซ้ำที่ไม่จำเป็น

อย่างไรก็ตาม หากผลลัพธ์ที่ได้รับแสดงข้อความว่า command not found หรือไม่พบคำสั่งดังกล่าว นั่นหมายความว่าอุปกรณ์ Spark ของคุณยังไม่มีการติดตั้ง Ollama ในขั้นตอนนี้คุณจำเป็นต้องดำเนินการติดตั้งโปรแกรมใหม่ให้เรียบร้อยก่อนจะนำไปใช้งานต่อ การรับทราบสถานะที่แน่นอนของระบบจะช่วยให้เราวางแผนขั้นตอนต่อไปได้อย่างถูกต้องและเหมาะสมกับสภาพแวดล้อมของระบบปัจจุบัน

เมื่อยืนยันแล้วว่ายังไม่มี Ollama ติดตั้งอยู่ ขั้นตอนต่อไปคือการดำเนินการติดตั้งผ่านสคริปต์อัตโนมัติที่ทีมงาน Ollama จัดเตรียมไว้ให้ ซึ่งวิธีนี้ถือเป็นวิธีที่ง่ายและรวดเร็วที่สุด ผู้ใช้งานเพียงแค่รันคำสั่ง curl -fsSL https://ollama.com/install.sh | sh บน Terminal ของอุปกรณ์ Spark คำสั่งนี้จะทำหน้าที่ดาวน์โหลดสคริปต์การติดตั้งจากเซิร์ฟเวอร์อย่างเป็นทางการและทำการดำเนินการติดตั้งไฟล์ไบนารีและส่วนประกอบต่างๆ ของ Ollama ลงในระบบโดยอัตโนมัติ

หลังจากรันคำสั่งแล้ว ระบบจะแสดงกระบวนการติดตั้งต่างๆ ผู้ใช้งานเพียงแค่รอจนกว่าขั้นตอนทั้งหมดจะเสร็จสมบูรณ์ ซึ่งโดยทั่วไปจะไม่ใช้เวลานานนัก เมื่อการติดตั้งเสร็จสิ้นลง ควรจะมีข้อความยืนยันการติดตั้งสำเร็จปรากฏขึ้นบนหน้าจอ หากเห็นข้อความดังกล่าวแสดงว่า Ollama พร้อมที่จะเริ่มใช้งานแล้ว และเราสามารถไปต่อที่ขั้นตอนการนำเข้าโมเดล AI ที่ต้องการใช้งานได้ทันที

การดาวน์โหลดโมเดล AI (Pull Model)

หลังจากที่ติดตั้ง Ollama เรียบร้อยแล้ว ขั้นตอนสำคัญต่อไปคือการดาวน์โหลดโมเดล AI ที่ต้องการใช้งานมายังอุปกรณ์ Spark ซึ่งในที่นี้เราจะใช้คำสั่ง ollama pull ตามด้วยชื่อโมเดลที่ต้องการ สำหรับการทดสอบนี้ขอแนะนำให้เป็นโมเดล qwen2.5 ขนาด 32b ซึ่งเป็นโมเดลที่มีขนาดใหญ่และได้รับการปรับแต่งให้ทำงานได้อย่างมีประสิทธิภาพบน Blackwell GPUs ที่ติดตั้งอยู่ในอุปกรณ์ NVIDIA Spark โดยเฉพาะ การเลือกใช้โมเดลที่เหมาะสมกับฮาร์ดแวร์จะช่วยให้การประมวลผลมีความรวดเร็วและแม่นยำยิ่งขึ้น

เมื่อทำการรันคำสั่งแล้ว ระบบจะเริ่มดาวน์โหลดไฟล์โมเดลซึ่งมีขนาดใหญ่อาจจะถึง 18 กิกะไบต์ขึ้นอยู่กับโมเดลที่เลือก หน้าจอจะแสดงความคืบหน้าของการดาวน์โหลดเป็นเปอร์เซ็นต์ ผู้ใช้งานควรรอให้ขั้นตอนนี้ดำเนินไปจนเสร็จสิ้นและตรวจสอบให้แน่ใจว่ามีข้อความว่า success ปรากฏขึ้น ซึ่งหมายความว่าโมเดลได้รับการนำเข้าและติดตั้งเรียบร้อยแล้ว พร้อมสำหรับการใช้งานในการวิเคราะห์และตอบคำถามต่อไป

การตั้งค่า NVIDIA Sync สำหรับการเข้าถึงระยะไกล

เพื่อให้สามารถเข้าถึง Ollama ที่รันอยู่บนอุปกรณ์ Spark จากเครื่องคอมพิวเตอร์ของเราได้ เราจะใช้ฟีเจอร์ Custom Apps ของ NVIDIA Sync เพื่อสร้าง SSH Tunnel ให้เริ่มจากการเปิดโปรแกรม NVIDIA Sync บนเครื่อง Local แล้วไปที่เมนู Settings หรือการตั้งค่า จากนั้นเลือกแท็บที่ชื่อว่า Custom เพื่อเริ่มต้นกำหนดค่าการเชื่อมต่อใหม่ ซึ่งแท็บนี้อนุญาตให้เรากำหนดรูปแบบการเชื่อมต่อแบบพิเศษที่ไม่ได้มีอยู่ในค่าเริ่มต้นของระบบ

ในหน้าต่าง Custom Apps ให้คลิกปุ่ม Add New เพื่อเพิ่มการตั้งค่าใหม่ จากนั้นทำการกรอกข้อมูลในช่องต่างๆ โดยระบุชื่อ (Name) ว่า Ollama Server เพื่อให้จำง่าย และระบุหมายเลขพอร์ต (Port) เป็น 11434 ซึ่งเป็นพอร์ตมาตรฐานที่ Ollama ใช้ในการรับส่งข้อมูล สำหรับส่วนอื่นๆ เช่น Auto open in browser สามารถเว้นว่างไว้ได้เนื่องจากเราจะใช้งานผ่าน API ไม่ใช่หน้าเว็บ จากนั้นกดบันทึกข้อมูล เมื่อบันทึกเสร็จแล้ว รายการ Ollama Server จะปรากฏอยู่ในรายการ Custom Apps ของคุณ พร้อมสำหรับการเปิดใช้งานในขั้นตอนถัดไป

การเปิดใช้งานอุโมงค์ (Tunnel Activation)

เมื่อตั้งค่า Custom App เสร็จเรียบร้อยแล้ว ขั้นตอนต่อไปคือการเปิดใช้งานอุโมงค์เพื่อเชื่อมต่อระหว่างเครื่อง Local และอุปกรณ์ Spark ให้คลิกที่ไอคอนของ NVIDIA Sync ในแถบ System tray หรือ Task bar แล้วมองหาส่วนที่เป็น Custom Apps ซึ่งจะมีรายการที่ชื่อ Ollama Server ที่เราเพิ่งสร้างขึ้นปรากฏอยู่ ให้ทำการคลิกที่ชื่อรายการดังกล่าวเพื่อเริ่มกระบวนการสร้างอุโมงค์เชื่อมต่อ

หลังจากคลิก ระบบจะทำการเชื่อมต่อ SSH ไปยังอุปกรณ์ Spark และทำการ forward พอร์ตจากเครื่อง Local ไปยังเซิร์ฟเวอร์ คุณสามารถตรวจสอบสถานะการเชื่อมต่อได้จากสัญลักษณ์สถานะ (Connection Status) ที่แสดงอยู่ข้างๆ ชื่อรายการ หากแสดงสถานะว่า Active หรือเชื่อมต่อแล้ว แสดงว่าอุโมงค์พร้อมใช้งานแล้ว ตอนนี้เครื่อง Local ของคุณสามารถคุยกับ Ollama บน Spark ได้เหมือนกับว่า Ollama รันอยู่บนเครื่องนี้โดยตรง

การทดสอบการเชื่อมต่อ API

ทดสอบการแชทพื้นฐาก

เพื่อยืนยันว่าระบบทั้งหมดทำงานได้อย่างถูกต้อง เราจะมาทดสอบการส่งคำสั่งผ่าน API ด้วย cURL บนเครื่อง Local Machine โดยตรง ให้เปิด Terminal บนเครื่องของคุณและพิมพ์คำสั่ง cURL เพื่อส่งคำขอ (Request) ไปยัง http://localhost:11434/api/chat ซึ่งเป็นพอร์ตที่เราได้ทำการ forward มาจากอุปกรณ์ Spark ผ่านอุโมงค์ SSH ที่เพิ่งสร้างขึ้น ในคำสั่งนี้จะต้องมีการกำหนดรูปแบบข้อมูล JSON ที่ระบุโมเดลที่ต้องการใช้และข้อความที่ต้องการสอบถามเข้าไปด้วย

หลังจากส่งคำสั่งแล้ว ให้สังเกตผลลัพธ์ที่แสดงบนหน้าจอ หากระบบทำงานถูกต้อง คุณจะได้รับข้อมูล Response กลับมาในรูปแบบ JSON ซึ่งภายในจะมีข้อความตอบโต้จากโมเดล AI ที่เราดาวน์โหลดไปติดตั้งไว้ การที่ได้รับข้อความตอบกลับสำเร็จแสดงว่าเส้นทางการเชื่อมต่อ API จากเครื่อง Local ไปยัง GPU บนอุปกรณ์ Spark ผ่าน NVIDIA Sync นั้นพร้อมใช้งานและปลอดภัย คุณสามารถนำ Endpoint นี้ไปต่อยอดใช้งานกับแอปพลิเคชันอื่นๆ ได้ทันที

การทำตามขั้นตอนทั้งหมดนี้จะทำให้คุณสามารถติดตั้งและใช้งาน Ollama บน NVIDIA Spark ได้อย่างราบรื่น พร้อมกับเข้าถึงพลังการประมวลผลของโมเดล AI ขนาดใหญ่จากเครื่องคอมพิวเตอร์ฝั่งตนเองได้อย่างสะดวกสบาย โดยไม่ต้องกังวลเรื่องความปลอดภัยของระบบเครือข่าย เนื่องจากการเชื่อมต่อทั้งหมดถูกส่งผ่าน SSH Tunnel ที่ปลอดภัยผ่าน NVIDIA Sync ซึ่งเป็นวิธีที่มีประสิทธิภาพและเสี่ยงต่ำในการนำเทคโนโลยี AI มาใช้งานจริงบนโครงสร้างพื้นฐานที่ทันสมัย

🎯 สรุปสั้นๆ

- ใช้ NVIDIA Sync เพื่อสร้าง SSH Tunnel ที่ปลอดภัยไปยัง Ollama Server บนอุปกรณ์ Spark โดยไม่ต้องเปิดพอร์ตเครือข่าย (Network Ports)

- สามารถติดตั้งและรันโมเดล AI ขนาดใหญ่ (เช่น Qwen2.5 32B) บน GPU ของ NVIDIA Spark ได้ง่ายๆ ด้วยสคริปต์ติดตั้งอัตโนมัติ

- เชื่อมต่อและสั่งงาน Ollama API จากเครื่อง Local Machine ได้เหมือนกับการรันในเครื่อง (ผ่าน localhost:11434)

- มีความเสี่ยงต่ำและสามารถย้อนกลับได้ง่าย (Rollback) หากต้องการยกเลิกการใช้งาน